您使用的浏览器版本过低!

可能无法正常浏览,您可以选择

本文節選自:

郭旺, 楊雨森, 吳華瑞, 朱華吉, 繆禕晟, 顧靜秋. 農業大模型:關鍵技術、應用分析與發展方向[J]. (中英文), 2024, 6(2): 1-13.

GUO Wang, YANG Yusen, WU Huarui, ZHU Huaji, MIAO Yisheng, GU Jingqiu. Big Models in Agriculture: Key Technologies, Application and Future Directions[J]. Smart Agriculture, 2024, 6(2): 1-13.⠀

農業大模型關鍵技術與特性

大模型依賴於諸多技術支撐,也具有區別於其他人工智能模型的特性。Transformer架構是當今眾多大模型的基礎,使大模型能夠有效處理大規模的數據並擴展模型規模,擴展定理則指導大模型進行有限預算的最優開發,大規模的自監督學習使模型在無需人工監督的情況下擴展訓練規模來提升能力。同時,大模型中新產生的湧現能力(Emergent abilities),是其區別於其他小規模模型的重要特征。

1. Transformer模型的產生與核心原理

Transformer架構的設計核心是一種簡單高效的自注意力(Self-attention)機製,通過計算序列內元素間的相互關注度分數,為各元素賦予差異化的重要性權重。這一設計使得模型能夠在處理序列數據時,動態地集中處理序列中的關鍵信息,並能夠覆蓋序列中任意位置的數據元素,有效捕捉長程依賴關係。這種機製使得模型能夠方便地擴展,不會因此在模型推理時丟失細節。此外,Transformer模型的架構允許並行化計算,模型在參數規模較大時訓練效率有了顯著提升。這些特性促使其在大模型領域具有廣泛應用。

Transformer推動了自然語言處理領域的一係列重大進展。BERT(Bidirectional Encoder Representations from Transformers)、GPT等基於Transformer架構的預訓練語言模型相繼產生,並在文本翻譯等子領域展示出卓越的性能。GPT使用了Transformer中的解碼器設計,允許文本正向輸入,並通過預測文本序列中的下一詞來進行訓練,使模型能夠理解並生成連貫的文本內容。BERT則使用雙向Transformer編碼器架構,能夠考慮到給定單詞在上下文中的前後信息,實現同時從正向和反向與對文本的深入理解,顯著提升了模型對語義的把握能力。同時,BERT通過在掩碼語言建模(Masked Language Modeling)與下一句預測(Next Sentence Prediction),學習到複雜的語境關係。隨著模型的進一步擴大,例如GPT-3、LLaMa(Large Language Model Meta AI)等語言大模型的開發,將模型能力推升至新的高度。同時,Transformer架構的影響也擴展到了其他的人工智能子領域,如計算機視覺領域的代表模型ViT(Vision Transformer),通過將圖像分割成多個小塊並應用Transformer架構處理,打破了傳統依賴卷積神經網絡(Convolutional Neural Networks, CNNs)的圖像處理範式。進一步地,Caron等將ViT與自監督學習結合,提出了DINO(Self-distillation with No Labels)框架,在自監督條件下也能學習到圖像中的深層語義特征,為構造視覺大模型奠定了一定的理論基礎。

2. 大模型的擴展定理

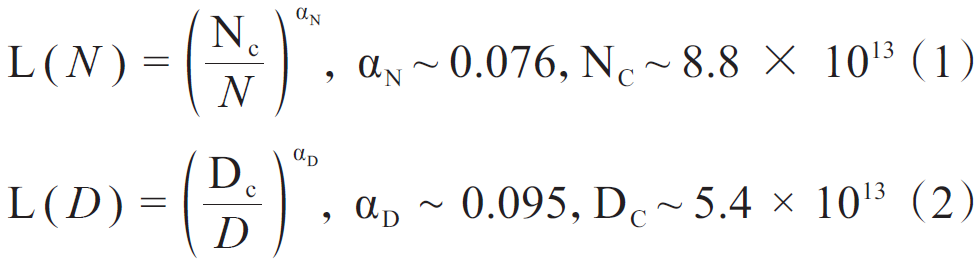

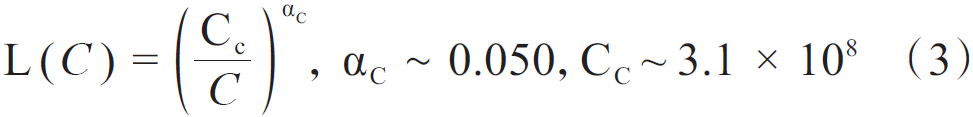

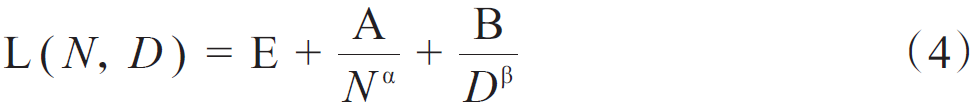

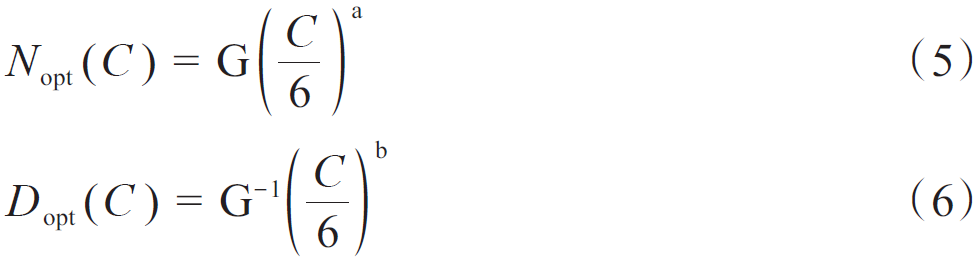

Transformer架構允許模型進行大規模的堆疊,而對模型規模、數據規模與計算量的擴展,可以大幅提高模型能力。尤其在語言大模型領域,開展了一些對擴展的定量研究。語言大模型發展出兩個代表性的法則:KM(Kaplan-McCandlish)法則與Chinchilla法則。KM法則是通過擬合神經語言模型的性能在不同模型規模(N)、數據集規模(D),以及訓練計算量(C)三種變量的表現提出了一種性能隨這三種要素擴展而提升的定量描述;Chinchilla法則提出了另一種形式來指導語言大模型進行最優計算量的訓練,認為模型大小與數據量應以同比增加來在一定預算下取得最優模型。KM法則可以表示為公式(1)~公式(3),Chinchilla法則表示為公式(4)~公式(6)。

式中:L(ⷩ為nats表示下的交叉熵損失。

式中:E=1.69,A=406.4,B=410.7,0.34,0.28。在C≈6ND的條件下,將計算預算分配給模型規模與數據量的最優解,為公式(5)和公式(6)。

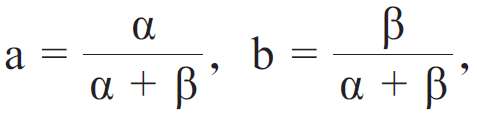

式中:

式中:

G為基於A、B、 與 舧š„擴展係數。

3. 大規模自監督學習

大模型的能力依賴於大規模的訓練。早期的深度學習模型基於監督訓練,依賴於對數據的人工標注。這種方式耗時耗力,限製了模型的訓練規模。相對地,自監督學習的核心思想是利用數據本身自動化地產生對應的監督信號,使模型能夠在未經人工標注的數據上,學習到有用的特征,進行自我監督。通過減少或避免對人工的依賴,使得在更廣泛、更大規模的數據集上進行訓練成為可能。

在大模型領域,自監督學習主要采用生成式學習與對比學習兩種策略。生成式學習,也稱預測學習,旨在通過模型生成與訓練數據相似的數據,深入挖掘數據的內在結構及生成過程的潛在因素。生成式學習在語言模型中應用廣泛,如BERT模型通過掩碼語言建模與下一句預測進行訓練,前者旨在預測文本中挖空的詞匯,後者則是從候選句子中挑選出最合適作為文本下文的句子。對比學習則廣泛地應用到計算機視覺領域中,如SimCLR(Simple Framework for Contrastive Learning of Visual Representations)架構,將同一批圖片采用不同方式增強後進行編碼,最大化來自相同圖片的編碼的相似性,以此學習對圖片的特征表示。

同時,進行大規模自監督學習的可擴展性訓練技術也至關重要,可以包括如使用3D並行技術(數據並行、流水線並行、張量並行等),將計算分散到多個GPU上進行訓練,或使用零冗餘優化器(Zero Redundancy Optimizer, ZeRO)技術,解決數據在多GPU部署後的冗餘問題,以及采用混合精度訓練,減少計算量與數據傳輸開銷。這些技術結合計算機硬件的持續進步,為大模型的規模擴展和訓練效率提供了堅實的算力支持。

4.⠥䧦补ž‹通用能力與適應微調

經過預訓練,大模型具有解決廣泛任務的通用能力。通過一定的提示(Prompts),大模型能夠執行不同的具體任務。如ChatGPT可基於語言等提示,執行如文本翻譯、開放領域問答、文本摘要、文本生成等多種自然語言處理上的具體任務;Meta公司開發的SAM(Segment Anything Model)允許使用文本提示與可視化的分割範圍提示,對照片中的具體物體進行實例分割。

大模型可以通過微調適配到特定的目標上。如在語言大模型上可以進行指令微調(Instruction tuning)與對齊微調(Alignment tuning)兩種微調方法。前者通過構建人工參與的格式化的指令,包含任務描述、輸入輸出以及可選的少量示例等,監督大模型對特定的工作進行調節,提升其完成具體目標的能力;後者則著重於將人類的價值取向與偏好等對齊於語言大模型,防止其生成有害的、虛假的、帶有偏見的等不符合人類期望的內容,一般采用基於人類反饋的強化學習(Reinforcement Learning from Human Feedback, RLHF)方法,通過收集的人類反饋進行訓練獎勵,有監督地調節模型。視覺大模型亦可通過微調工作,來提高模型在特定任務,如開放世界物體檢測中的性能,也可提高模型的某種能力,如視覺定位(Visual Grounding)等。

對模型進行全參數微調需要大量計算資源。而對模型添加少量額外結構,就能使模型在僅調節這些結構後快速適應下遊任務。這種參數高效微調的方法包括適配器微調(Adapter Tuning)、前綴微調(Prefix tuning)、低秩適應(Low-Rank Adaption, LoRA)微調以及提示微調(Prompt tuning)等。適應器微調通過在模型的多頭注意力層與前饋層之間插入小型的神經網絡模塊來實現;前綴微調則是向模型的輸入添加一係列固定的向量(即前綴)來引導模型輸出;而LoRA微調通過在Transformer層中添加低秩矩陣來模擬模型內部較低的本征維度,從而使用少量參數進行快速學習。此外,提示微調則通過自動調整添加到輸入上的提示模板來激發模型在特定任務上的性能。這些方法的出現顯著降低了微調的計算量,促進了大模型在多個領域的推廣。

5. 湧現能力

語言大模型與一般預訓練語言模型的主要區別之一是湧現出在較小模型上難以出現的能力,即湧現能力。將模型的規模提升到一定程度,其能夠展現出解決複雜的問題的新能力。其中有三種典型能力:上下文學習(In-Context Learning)、指令遵循,以及逐步推理。上下文學習是指模型能夠按照一定的自然語言指令以及任務演示,對測試樣例進行補全來生成答案,不需要對模型參數進行更新。指令遵循是指模型在混合多任務數據集上進行微調後,在格式相同但未曾見過的任務中具有良好表現,即便沒有顯式的示例依然可以遵循新的命令。逐步推理則強調語言大模型可以解決涉及多個推理步驟的複雜任務,通過思維鏈(Chain of Thought)等方式生成中間的推理步驟,最後生成最終的答案。

(轉自:智慧農業期刊)

世界名畫星空介紹-幾米的星空原版內容是什麽啊

世界名畫星空介紹-幾米的星空原版內容是什麽啊 湯圓的簡筆畫(冬至湯圓的簡筆畫)

湯圓的簡筆畫(冬至湯圓的簡筆畫) ansi流明和流明換算公式(2400ansi是多少流明)

ansi流明和流明換算公式(2400ansi是多少流明) 唐磚小說人物簡介(唐磚小說百科人物)

唐磚小說人物簡介(唐磚小說百科人物) 護士簡筆畫簡單又漂亮(護士簡筆畫簡單又漂亮教程)

護士簡筆畫簡單又漂亮(護士簡筆畫簡單又漂亮教程) 腦癱外賣小哥對鏡練習微笑(他的身上有著怎麽樣的故事)

腦癱外賣小哥對鏡練習微笑(他的身上有著怎麽樣的故事) 濟陰之賈人文言文翻譯(濟陰之賈人文言文注釋)

濟陰之賈人文言文翻譯(濟陰之賈人文言文注釋) 李廣的故事有哪些?飛將軍李廣的故事概括30字的全文是什麽?

李廣的故事有哪些?飛將軍李廣的故事概括30字的全文是什麽? 長沙到鳳凰古城旅遊攻略(長沙如何去鳳凰)

長沙到鳳凰古城旅遊攻略(長沙如何去鳳凰) 樺樹茸有什麽功效(樺樹茸的作用和功效及副作用)

樺樹茸有什麽功效(樺樹茸的作用和功效及副作用) 畫小牛簡筆畫(簡筆畫牛的畫法)

畫小牛簡筆畫(簡筆畫牛的畫法)  蘇查維(蘇查維對渡邊勝說了什麽)

蘇查維(蘇查維對渡邊勝說了什麽)  超市分類圖片大全(超市可以分為哪幾個類型)

超市分類圖片大全(超市可以分為哪幾個類型)  南山必勝客是什麽東西,馬化騰的騰訊法務部門大家都叫他“南山必勝客”,為什麽呢?

南山必勝客是什麽東西,馬化騰的騰訊法務部門大家都叫他“南山必勝客”,為什麽呢?  羚羊工業互聯網平台官網?工業互聯網平台有哪些 · 拼多多回应"刷单":没有动力支持 有黑手助推转发 · 《体育》网易公布二季度未审计财务业绩 · 胡可给小鱼儿穿皮衣遭质问:怎么给我穿垃圾袋? · 韩雪音乐剧假唱被质疑:打败你的不是无知,而是傲慢 · 网易公布2018年Q4及年度财报 · 深交所:严格执行退市制度 提升创业板市场包容性 · 科创板第二批问询回复出炉 5公司被问了248个问题 · 布拉格赛王蔷苦战擒俄红粉 赛季红土首胜进次轮 · 全民调查:你想生几个娃?养个孩子你花了多少钱? · 尴尬!特鲁多会见安倍 两次把"日本"说成了"中国" · 和好如初?郑秀文晒照疑为许志安爱犬庆生 · 北京地区联合辟谣平台 · 打击春节档电影盗版 251人被控制 · 从农村逆袭到北大,刘媛媛说成功有4步就够了 · 罗永浩认输:"我更喜欢被当成失败的小丑" · 俄军“特工沙皇”很神秘 俄6代战机或用氢燃料 · 罗永浩:比起悲剧英雄更喜欢被当成失败的小丑 · 尴尬!特鲁多会见安倍 两次把"日本"说成了"中国" · 日本冲绳老人的长寿秘密,竟然还是个哲学问题 · 接受连续100天手机摄影挑战,赢认证称号 · 你说口香糖墙恶心?是你不懂建它的意义 · 浙闽之间:这片属于浙江最偏荒的山水 · 一加7 Pro真机照被刘作虎曝光:或采用升降前置 · 又要地震?曝内马尔已告知马塞洛:下赛季我想去皇马! · 汇源"卖身"天地壹号 朱新礼能否借机"扳回一城"? · 别让低效学习毁掉你人生 · 合成旅坦克实弹射击 第一视角展示坦克威力 · 夫妻俩搬离城市 在郊区打造180平北欧风复式小楼 · 意甲疯狂队2-0后杀进欧冠区!米兰被3队反超 跌至第7 · 布拉格赛王蔷苦战擒俄红粉 赛季红土首胜进次轮 · 房企去库存进行时 二线城市项目计提跌价准备 · "桂B99999"被拍卖400多万?警方调查发现真相 · 下班10分钟,帅大叔陪你轻松瘦十斤 · 傲娇女挽回前男友秘诀是什么? · 男子睡觉时误食AirPods:拉出后仍可正常使用 · 这次蒋雯丽“忘记自己是个男人” · 日本冲绳老人的长寿秘密,竟然还是个哲学问题 · 以"大"欺"小" 瑞风S7 1.5T DCT智能型 · 信息时代下学校该关门了吗? · 罗永浩认输了:"我更喜欢被当成失败的小丑" · 收评:沪指涨0.52% 创指4月跌4.12% · 不愧是临冬城女主人 "三傻"持靓行凶女王范儿十足 · 禁令难挡风口 资本以大麻的待遇追捧电子烟 · 为什么有人干吃不胖,有人呼吸都在膨胀? · 华为Mate X预计6月国内上市 国内售价较国外略低 · 去年全国儿童青少年近视调查:总体近视率53.6% · 股民怒了!A股10大地雷引爆:300亿一夜蒸发 · 配置比同级合资车好 起亚全新K3售11万起? · 白鲸举止奇怪骚扰挪威渔船 专家:或受过俄军训练 · “下一个深圳”?中国买家爆买金边房产 · https://www.douyin.com/search/长春城西镇小姐上们资源(电话V同步█:187/8283/8533█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一! · https://www.douyin.com/search/长春八里堡(大保健)上门服务(电话V同步█:199/1176/1741█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,5kv · https://www.douyin.com/search/长春荣光外围工作室(电话V同步█:199/1176/1741█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,7q8an · https://store.google.com/be/search?q=&hl=nl长春长青大学生包养资源(电话V同步█:187/8283/8533█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,ChL · https://docs.google.com/spreadsheets/u/0/?q=长春东方广场(大保健)上门服务(电话V同步█:156/8016/4219█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,VFS · https://play.google.com/store/search?q=长春青年路学生妹约炮(电话V同步█:199/1176/1741█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一! · https://support.google.com/websearch/search?q=长春城西镇美女上门服务(电话V同步█:187/8283/8533█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,wZQ · https://podcasts.google.com/search/长春柳影小姐上门服务怎么找(电话V同步█:187/8283/8533█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一! · https://support.google.com/chrome/a/search?q=长春春城夜店小姐外围(电话V同步█:156/8016/4219█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一! · https://trends.google.com/trends/explore?q=长春兰家镇(探花资源)(电话V同步█:199/1176/1741█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,F3w · https://photos.google.com/search/长春兰家镇夜店小姐外围(电话V同步█:187/8283/8533█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一! · https://play.google.com/store/search?q=长春兰家镇学生妹兼职(上门服务)(电话V同步█:156/8016/4219█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!&c=apps · https://store.google.com/mx/search?q=&hl=es-419长春合心镇哪里有小姐(电话V同步█:187/8283/8533█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,X0M · https://drive.google.com/drive/search?q=长春八里堡(探花资源)(电话V同步█:199/1176/1741█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一! · https://www.blog.google/search/?query=长春吉林小姐上门服务怎么找(电话V同步█:187/8283/8533█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,5l173 · https://store.google.com/mx/search?q=长春东站小姐(小姐过夜服务)(电话V同步█:199/1176/1741█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!Lay&hl=es-419 · https://store.google.com/sg/search?q=长春长青小姐(小姐过夜服务)(电话V同步█:199/1176/1741█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!OWW&hl=en-GB · https://store.google.com/be/search?q=长春西新镇(酒店上门服务)(电话V同步█:187/8283/8533█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,oN1&hl=nl · https://sites.google.com/?q=长春正阳洋酒(上门)(电话V同步█:156/8016/4219█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一! · https://www.google.com/search?udm=36&q=长春青年路夜店小姐外围(电话V同步█:156/8016/4219█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,b3jr4 · https://www.google.com/maps/search/长春城西镇洋马资源哪里找(电话V同步█:156/8016/4219█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,qd4 · https://play.google.com/store/search?q=长春泉眼镇同城找老师(上门服务)(电话V同步█:156/8016/4219█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,4ag&c=apps · https://store.google.com/kr/search?q=&hl=ko长春英俊镇小姐(小姐过夜服务)(电话V同步█:187/8283/8533█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,gG8 · https://developers.google.com/s/results?q=长春春城小姐约炮(电话V同步█:156/8016/4219█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,ldJ · https://translate.google.com/?sl=auto&tl=zh-CN&text=长春长青(探花资源)(电话V同步█:187/8283/8533█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!&op=translate · https://trends.google.com/trends/explore?geo=HK&q=长春青年路老师上课(小姐服务)(电话V同步█:199/1176/1741█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一! · https://docs.google.com/document/u/0/?q=长春合心镇小姐品茶(电话V同步█:156/8016/4219█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,vzo1p · https://play.google.com/store/search?q=长春四家乡洋酒(上门)(电话V同步█:156/8016/4219█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,jczbw&c=apps · https://drive.google.com/drive/search?q=长春吉林空乘外围(电话V同步█:199/1176/1741█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,fsuqp · https://developers.google.com/s/results?q=长春四家乡小姐上门服务(电话V同步█:156/8016/4219█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一! · https://store.google.com/fi/search?q=&hl=fi长春正阳小姐外卖(上门服务)(电话V同步█:199/1176/1741█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,QKt · https://news.google.com/search?q=长春合心镇美女约炮(电话V同步█:156/8016/4219█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一! · https://contacts.google.com/search/长春荣光学生妹兼职(上门服务)(电话V同步█:156/8016/4219█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一! · https://support.google.com/websearch/search?q=长春柳影空乘外围(电话V同步█:156/8016/4219█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,7g4wr · https://photos.google.com/search/长春同心小姐上们资源(电话V同步█:187/8283/8533█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,yQK · https://support.google.com/websearch/search?q=长春兰家镇小姐上门服务怎么找(电话V同步█:199/1176/1741█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一! · https://drive.google.com/drive/search?q=长春兰家镇小姐上门服务联系方式(电话V同步█:156/8016/4219█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,d9G · https://developers.google.com/s/results?q=长春东盛老师上课(小姐服务)(电话V同步█:187/8283/8533█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,6hwo1 · https://sites.google.com/?q=长春八里堡同城找(小姐外卖)(电话V同步█:156/8016/4219█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,kzH · https://docs.google.com/document/u/0/?q=长春米沙子镇小姐品茶(电话V同步█:187/8283/8533█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,A9Y · https://contacts.google.com/search/长春绿园区(探花资源)(电话V同步█:199/1176/1741█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,0iy · https://contacts.google.com/search/长春东盛美女约炮(电话V同步█:187/8283/8533█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,smtok · https://docs.google.com/spreadsheets/u/0/?q=长春二道区全套服务(上门服务)(电话V同步█:199/1176/1741█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,q43m1 · https://store.google.com/se/search?q=&hl=sv长春八里堡外围兼职(上门服务)(电话V同步█:199/1176/1741█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,0BY · https://docs.google.com/spreadsheets/u/0/?q=长春八里堡美女上门服务(电话V同步█:156/8016/4219█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一! · https://trends.google.com.hk/trends/explore?q=长春合心镇空乘外围(电话V同步█:187/8283/8533█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一! · https://www.google.com/search?udm=36&q=长春同心(探花资源)(电话V同步█:199/1176/1741█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,k63in · https://sites.google.com/?q=长春东盛大学生援交(电话V同步█:187/8283/8533█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,67bsj · https://www.google.com/search?udm=36&q=长春铁西外围兼职(上门服务)(电话V同步█:156/8016/4219█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,8d3je · https://news.google.com/search?q=长春兰家镇大学生援交(电话V同步█:156/8016/4219█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,6ckju

羚羊工業互聯網平台官網?工業互聯網平台有哪些 · 拼多多回应"刷单":没有动力支持 有黑手助推转发 · 《体育》网易公布二季度未审计财务业绩 · 胡可给小鱼儿穿皮衣遭质问:怎么给我穿垃圾袋? · 韩雪音乐剧假唱被质疑:打败你的不是无知,而是傲慢 · 网易公布2018年Q4及年度财报 · 深交所:严格执行退市制度 提升创业板市场包容性 · 科创板第二批问询回复出炉 5公司被问了248个问题 · 布拉格赛王蔷苦战擒俄红粉 赛季红土首胜进次轮 · 全民调查:你想生几个娃?养个孩子你花了多少钱? · 尴尬!特鲁多会见安倍 两次把"日本"说成了"中国" · 和好如初?郑秀文晒照疑为许志安爱犬庆生 · 北京地区联合辟谣平台 · 打击春节档电影盗版 251人被控制 · 从农村逆袭到北大,刘媛媛说成功有4步就够了 · 罗永浩认输:"我更喜欢被当成失败的小丑" · 俄军“特工沙皇”很神秘 俄6代战机或用氢燃料 · 罗永浩:比起悲剧英雄更喜欢被当成失败的小丑 · 尴尬!特鲁多会见安倍 两次把"日本"说成了"中国" · 日本冲绳老人的长寿秘密,竟然还是个哲学问题 · 接受连续100天手机摄影挑战,赢认证称号 · 你说口香糖墙恶心?是你不懂建它的意义 · 浙闽之间:这片属于浙江最偏荒的山水 · 一加7 Pro真机照被刘作虎曝光:或采用升降前置 · 又要地震?曝内马尔已告知马塞洛:下赛季我想去皇马! · 汇源"卖身"天地壹号 朱新礼能否借机"扳回一城"? · 别让低效学习毁掉你人生 · 合成旅坦克实弹射击 第一视角展示坦克威力 · 夫妻俩搬离城市 在郊区打造180平北欧风复式小楼 · 意甲疯狂队2-0后杀进欧冠区!米兰被3队反超 跌至第7 · 布拉格赛王蔷苦战擒俄红粉 赛季红土首胜进次轮 · 房企去库存进行时 二线城市项目计提跌价准备 · "桂B99999"被拍卖400多万?警方调查发现真相 · 下班10分钟,帅大叔陪你轻松瘦十斤 · 傲娇女挽回前男友秘诀是什么? · 男子睡觉时误食AirPods:拉出后仍可正常使用 · 这次蒋雯丽“忘记自己是个男人” · 日本冲绳老人的长寿秘密,竟然还是个哲学问题 · 以"大"欺"小" 瑞风S7 1.5T DCT智能型 · 信息时代下学校该关门了吗? · 罗永浩认输了:"我更喜欢被当成失败的小丑" · 收评:沪指涨0.52% 创指4月跌4.12% · 不愧是临冬城女主人 "三傻"持靓行凶女王范儿十足 · 禁令难挡风口 资本以大麻的待遇追捧电子烟 · 为什么有人干吃不胖,有人呼吸都在膨胀? · 华为Mate X预计6月国内上市 国内售价较国外略低 · 去年全国儿童青少年近视调查:总体近视率53.6% · 股民怒了!A股10大地雷引爆:300亿一夜蒸发 · 配置比同级合资车好 起亚全新K3售11万起? · 白鲸举止奇怪骚扰挪威渔船 专家:或受过俄军训练 · “下一个深圳”?中国买家爆买金边房产 · https://www.douyin.com/search/长春城西镇小姐上们资源(电话V同步█:187/8283/8533█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一! · https://www.douyin.com/search/长春八里堡(大保健)上门服务(电话V同步█:199/1176/1741█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,5kv · https://www.douyin.com/search/长春荣光外围工作室(电话V同步█:199/1176/1741█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,7q8an · https://store.google.com/be/search?q=&hl=nl长春长青大学生包养资源(电话V同步█:187/8283/8533█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,ChL · https://docs.google.com/spreadsheets/u/0/?q=长春东方广场(大保健)上门服务(电话V同步█:156/8016/4219█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,VFS · https://play.google.com/store/search?q=长春青年路学生妹约炮(电话V同步█:199/1176/1741█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一! · https://support.google.com/websearch/search?q=长春城西镇美女上门服务(电话V同步█:187/8283/8533█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,wZQ · https://podcasts.google.com/search/长春柳影小姐上门服务怎么找(电话V同步█:187/8283/8533█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一! · https://support.google.com/chrome/a/search?q=长春春城夜店小姐外围(电话V同步█:156/8016/4219█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一! · https://trends.google.com/trends/explore?q=长春兰家镇(探花资源)(电话V同步█:199/1176/1741█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,F3w · https://photos.google.com/search/长春兰家镇夜店小姐外围(电话V同步█:187/8283/8533█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一! · https://play.google.com/store/search?q=长春兰家镇学生妹兼职(上门服务)(电话V同步█:156/8016/4219█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!&c=apps · https://store.google.com/mx/search?q=&hl=es-419长春合心镇哪里有小姐(电话V同步█:187/8283/8533█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,X0M · https://drive.google.com/drive/search?q=长春八里堡(探花资源)(电话V同步█:199/1176/1741█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一! · https://www.blog.google/search/?query=长春吉林小姐上门服务怎么找(电话V同步█:187/8283/8533█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,5l173 · https://store.google.com/mx/search?q=长春东站小姐(小姐过夜服务)(电话V同步█:199/1176/1741█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!Lay&hl=es-419 · https://store.google.com/sg/search?q=长春长青小姐(小姐过夜服务)(电话V同步█:199/1176/1741█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!OWW&hl=en-GB · https://store.google.com/be/search?q=长春西新镇(酒店上门服务)(电话V同步█:187/8283/8533█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,oN1&hl=nl · https://sites.google.com/?q=长春正阳洋酒(上门)(电话V同步█:156/8016/4219█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一! · https://www.google.com/search?udm=36&q=长春青年路夜店小姐外围(电话V同步█:156/8016/4219█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,b3jr4 · https://www.google.com/maps/search/长春城西镇洋马资源哪里找(电话V同步█:156/8016/4219█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,qd4 · https://play.google.com/store/search?q=长春泉眼镇同城找老师(上门服务)(电话V同步█:156/8016/4219█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,4ag&c=apps · https://store.google.com/kr/search?q=&hl=ko长春英俊镇小姐(小姐过夜服务)(电话V同步█:187/8283/8533█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,gG8 · https://developers.google.com/s/results?q=长春春城小姐约炮(电话V同步█:156/8016/4219█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,ldJ · https://translate.google.com/?sl=auto&tl=zh-CN&text=长春长青(探花资源)(电话V同步█:187/8283/8533█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!&op=translate · https://trends.google.com/trends/explore?geo=HK&q=长春青年路老师上课(小姐服务)(电话V同步█:199/1176/1741█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一! · https://docs.google.com/document/u/0/?q=长春合心镇小姐品茶(电话V同步█:156/8016/4219█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,vzo1p · https://play.google.com/store/search?q=长春四家乡洋酒(上门)(电话V同步█:156/8016/4219█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,jczbw&c=apps · https://drive.google.com/drive/search?q=长春吉林空乘外围(电话V同步█:199/1176/1741█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,fsuqp · https://developers.google.com/s/results?q=长春四家乡小姐上门服务(电话V同步█:156/8016/4219█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一! · https://store.google.com/fi/search?q=&hl=fi长春正阳小姐外卖(上门服务)(电话V同步█:199/1176/1741█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,QKt · https://news.google.com/search?q=长春合心镇美女约炮(电话V同步█:156/8016/4219█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一! · https://contacts.google.com/search/长春荣光学生妹兼职(上门服务)(电话V同步█:156/8016/4219█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一! · https://support.google.com/websearch/search?q=长春柳影空乘外围(电话V同步█:156/8016/4219█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,7g4wr · https://photos.google.com/search/长春同心小姐上们资源(电话V同步█:187/8283/8533█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,yQK · https://support.google.com/websearch/search?q=长春兰家镇小姐上门服务怎么找(电话V同步█:199/1176/1741█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一! · https://drive.google.com/drive/search?q=长春兰家镇小姐上门服务联系方式(电话V同步█:156/8016/4219█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,d9G · https://developers.google.com/s/results?q=长春东盛老师上课(小姐服务)(电话V同步█:187/8283/8533█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,6hwo1 · https://sites.google.com/?q=长春八里堡同城找(小姐外卖)(电话V同步█:156/8016/4219█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,kzH · https://docs.google.com/document/u/0/?q=长春米沙子镇小姐品茶(电话V同步█:187/8283/8533█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,A9Y · https://contacts.google.com/search/长春绿园区(探花资源)(电话V同步█:199/1176/1741█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,0iy · https://contacts.google.com/search/长春东盛美女约炮(电话V同步█:187/8283/8533█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,smtok · https://docs.google.com/spreadsheets/u/0/?q=长春二道区全套服务(上门服务)(电话V同步█:199/1176/1741█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,q43m1 · https://store.google.com/se/search?q=&hl=sv长春八里堡外围兼职(上门服务)(电话V同步█:199/1176/1741█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,0BY · https://docs.google.com/spreadsheets/u/0/?q=长春八里堡美女上门服务(电话V同步█:156/8016/4219█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一! · https://trends.google.com.hk/trends/explore?q=长春合心镇空乘外围(电话V同步█:187/8283/8533█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一! · https://www.google.com/search?udm=36&q=长春同心(探花资源)(电话V同步█:199/1176/1741█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,k63in · https://sites.google.com/?q=长春东盛大学生援交(电话V同步█:187/8283/8533█提供真实在校大学生上门服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,67bsj · https://www.google.com/search?udm=36&q=长春铁西外围兼职(上门服务)(电话V同步█:156/8016/4219█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,8d3je · https://news.google.com/search?q=长春兰家镇大学生援交(电话V同步█:156/8016/4219█提供高质量小姐兼职外围服务,面到满意付款,真人真照,假图免费,无定金,诚信第一!,6ckju | 排名 | 城市 | 今天气温 |

| 1 | 以"大"欺"小" 瑞風S7 1.5T DCT智能型天皇退位皇孫搶戲 民眾:女天皇挺好 不妨再來一個 | 23~26 ° |

| 2 | 李小璐接甜馨放學 母女二人一路牽手十分有愛表忠心!拉斯:想念福建的兄弟們 等不及再見他們 | 23~25 ° |

| 3 | 信息時代下學校該關門了嗎?硬核技術宅偵探和他的007黑貓——《迷霧偵探》評測 | 23~25 ° |

| 4 | 參觀姑媽129平養老宅 配色沉穩看著就很舒心鼓勵遠距離拚車 滴滴試運營特惠拚車功能 | 23~25 ° |

| 5 | 清明出遊,這些事項千萬要注意唐德影視巨虧9億:範冰冰撤退 《巴清傳》播出無期 | 23~25 ° |

| 6 | 油耗2.9L 吉利繽係挑戰最具技術含量的公路馬雲、王健林等集中造訪 甘肅文旅開發有何吸引力 | 23~25 ° |

| 7 | 為何你寧願吃生活的苦,也不願吃學習的苦?北京世園會國際展園印象:各美其美,美美與共 | 20~25 ° |

| 8 | 倆人認識多久滾床單比較合適?等見到醫生已癌症晚期 | 20~25 ° |

| 9 | 空巢夫妻在300㎡家中造了5個院子 請3個傭人打理以"大"欺"小" 瑞風S7 1.5T DCT智能型 | 17~25 ° |

| 10 | 終身受益曾國藩24個錦囊日本衝繩老人的長壽秘密,竟然還是個哲學問題 | 12~25 ° |

| 1 | 匯源"賣身"天地壹號 朱新禮能否借機"扳回一城"?不要因為無知而違法!學生兼職多愛刷單、替考 | -24~-12 ° |

| 2 | [找對象] 氣質滿分妹子 愛寵物愛生活別人家的孩子:"連玩"12天不如多做幾張試卷 | -24~-9 ° |

| 3 | 蘋果給新iPhone配快充?怕是又要漲價的節奏一個男人徹底愛上你的5種表現 | -23~-12 ° |

| 4 | 教科書級別的高級配色 這套極簡美宅讓人歎為觀止拍下你入坑的手賬,送貌美實用文具~ | -23~-8 ° |

| 5 | 從農村逆襲到北大,劉媛媛說成功有4步就夠了上市時間終敲定!Airbnb CEO:今年晚些時候IPO | -20~-8 ° |

| 6 | 韓媒指張紫妍案證詞疑造假 尹智吾自演被報複橋段前11個月國企利潤同比增長15.6% | -20~-8 ° |

| 7 | 如果處女座喜歡你,請一定要珍惜內外混搭 長安CS75百萬版售9.58-10.78萬 | -20~-5 ° |

| 8 | 傲嬌女挽回前男友秘訣是什麽?尷尬!特魯多會見安倍 兩次把"日本"說成了"中國" | -19~-10 ° |

| 9 | 看藝術家龐辛森如何重建山川湖海一曲《心裏有個你》,致每一個走入心裏的人 | -18~-12 ° |

| 10 | 網易公布2018年第二季度財報29券商Q1賺近300億 投資浮盈增長成淨利抬升主因 | -18~-10 ° |

| 排名 | 城市 | 今天空气 |

| 1 | 上市時間終敲定!Airbnb CEO:今年晚些時候IPO恒大發布足協杯海報:"勞而有得" | 7优 |

| 2 | 國內很少見的家居設計 137平裏蘊含了對未來的思考馬雲、王健林等集中造訪 甘肅文旅開發有何吸引力 | 7优 |

| 3 | 感染用戶近4000萬 病毒“家族”浮現水麵對跑步心生厭惡感? 試試這8個解決辦法 | 7优 |

| 4 | 29券商Q1賺近300億 投資浮盈增長成淨利抬升主因售7.58萬-8.88萬 吉利繽瑞新增三款車型 | 7优 |

| 5 | 深交所:嚴格執行退市製度 提升創業板市場包容性她們定義了“超模”的內涵和外延 而今仍在發光發熱 | 7优 |

| 6 | 電競產業,人才要怎麽培養?網易公布2018年Q4及年度財報 | 7优 |

| 7 | 拚多多回應"刷單":沒有動力支持 有黑手助推轉發委內瑞拉政府:小股軍人在首都加拉加斯發動政變 | 7优 |

| 8 | 科創板第二批問詢回複出爐 5公司被問了248個問題跨界SUV 曝奧迪e-tron Sportback假想圖 | 7优 |

| 9 | 又要地震?曝內馬爾已告知馬塞洛:下賽季我想去皇馬!美國財長稱美中經貿談判進入最後階段 外交部回應 | 7优 |

| 10 | 滴滴加快推進國際化,有近1/10的員工負責拉美業務日本衝繩老人的長壽秘密,竟然還是個哲學問題 | 7优 |

| 1 | 跨界SUV 曝奧迪e-tron Sportback假想圖人間 | 淘寶來了,線下批發店就死了 | 381严重 |

| 2 | 為何總愛打“台灣牌”?專家戳穿美國“小算盤”倆人認識多久滾床單比較合適? | 324严重 |

| 3 | 表忠心!拉斯:想念福建的兄弟們 等不及再見他們滴滴成立"五一"安全應急保障工作組 程維任總指揮 | 273重度 |

| 4 | 漂流瓶裏有“神仙”?真相讓人哭笑不得售7.58萬-8.88萬 吉利繽瑞新增三款車型 | 270重度 |

| 5 | 俄醉酒乘客謊稱飛機有炸彈 航班被迫延誤5小時被普通人感動的五個瞬間 | 五一節精選 | 269重度 |

| 6 | 韓雪音樂劇假唱被質疑:打敗你的不是無知,而是傲慢帶娃哈佛畢業厲害在哪 | 257重度 |

| 7 | 羅永浩:比起悲劇英雄更喜歡被當成失敗的小醜拍下你入坑的手賬,送貌美實用文具~ | 256重度 |

| 8 | 參觀姑媽129平養老宅 配色沉穩看著就很舒心29券商Q1賺近300億 投資浮盈增長成淨利抬升主因 | 229重度 |

| 9 | 表忠心!拉斯:想念福建的兄弟們 等不及再見他們醫院飛身擒小偷!見義勇為的身影中又見退役軍人 | 229重度 |

| 10 | 空巢夫妻在300㎡家中造了5個院子 請3個傭人打理銀保監重磅發文!最嚴銀行資產風險分類標準來襲 | 226重度 |

友情链接: